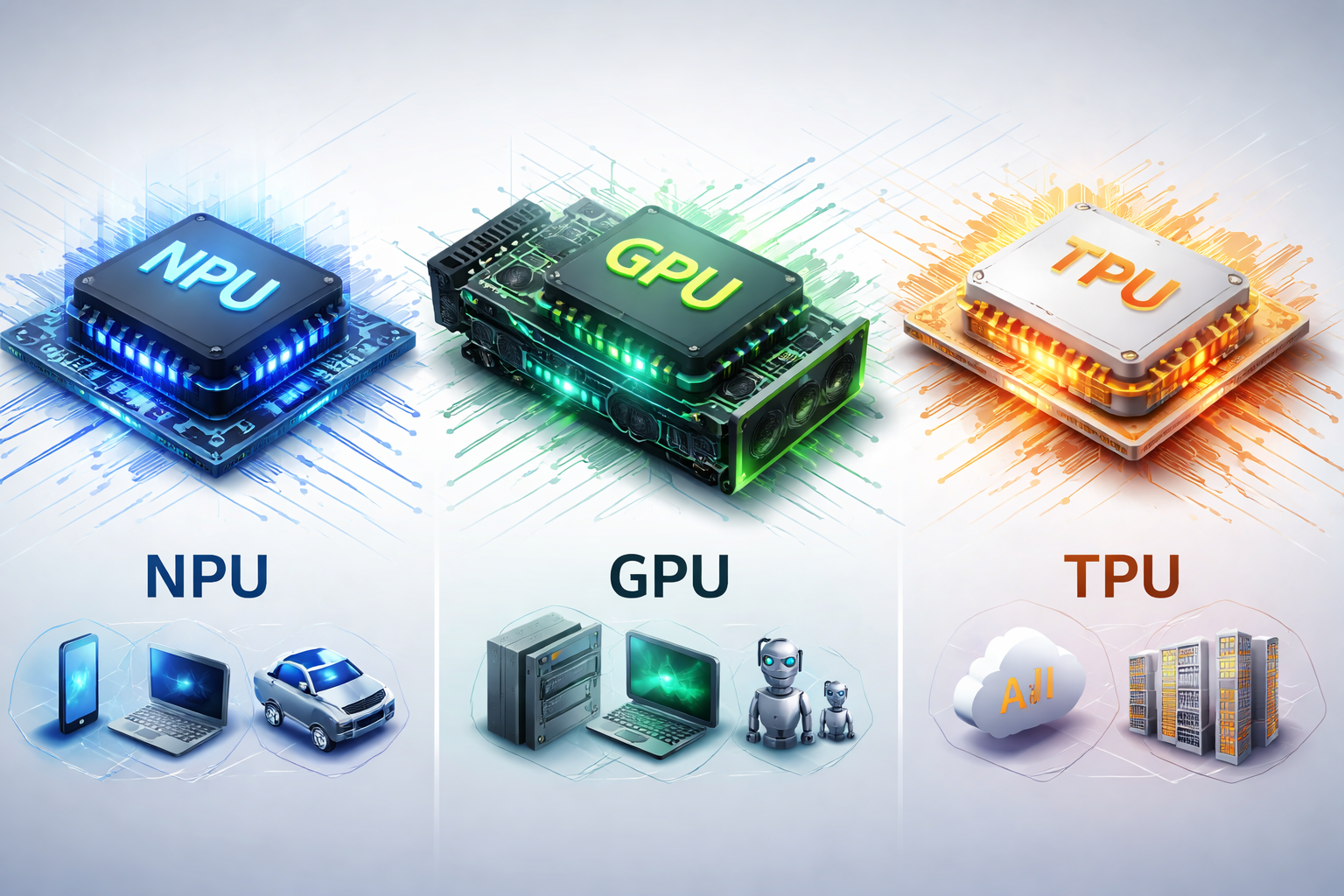

NPU vs GPU vs TPU 비교 분석: AI 가속기 3대장, 언제 무엇을 써야 할까?

AI가 대중화되면서 “내 노트북/스마트폰엔 NPU가 있다”, “서버는 GPU가 필수다”, “구글은 TPU로 학습한다” 같은 말이 흔해졌습니다. 그런데 셋은 같은 ‘AI 칩’으로 묶이지만, 설계 목적과 강점이 꽤 다릅니다. 이 글은 목적–구조–성능/효율–활용 시나리오 관점에서 NPU·GPU·TPU를 한 번에 비교 정리합니다.

I. 한눈에 보는 핵심 요약

결론부터 말하면, GPU는 범용 병렬 가속기로 학습/추론 모두에 강하고, NPU는 온디바이스 추론에 특화된 저전력 “기기 속 AI 전용 엔진”이며, TPU는 구글이 데이터센터 규모 AI를 위해 만든 전용 ASIC입니다.

| 구분 | NPU | GPU | TPU |

|---|---|---|---|

| 정체성 | 온디바이스 AI 전용 | 범용 병렬 가속기 | 구글 전용 AI ASIC |

| 주 용도 | 추론(Inference) 중심 | 학습 + 추론 | 대규모 학습 + 추론 |

| 전력 효율 | 매우 높음 | 상대적으로 낮음 | 매우 높음(데이터센터 최적) |

| 유연성 | 낮음(특화) | 매우 높음(범용) | 낮음(구글 생태계 중심) |

| 대표 환경 | 스마트폰·AI PC·차량·IoT | 서버·워크스테이션·연구 | Google Cloud |

학습(training)은 GPU/TPU, 기기 내 실시간 AI(온디바이스 추론)는 NPU가 유리합니다.

II. 구조적 차이: 왜 성향이 갈리는가

2-1. GPU: “뭐든 병렬로 크게” 처리하는 범용 가속기

GPU는 원래 그래픽 렌더링을 위해 발전해 온 하드웨어로, 대규모 병렬 처리에 강합니다. 딥러닝의 핵심인 행렬/텐서 연산도 병렬화가 잘 되기 때문에, 현재까지도 대부분의 AI 학습은 GPU가 표준처럼 사용됩니다.

- 수천 개 코어 기반 병렬 처리

FP32/FP16/INT8등 다양한 정밀도 지원- 생태계가 매우 성숙(CUDA/ROCm, 프레임워크 최적화)

2-2. NPU: “AI 연산만” 아주 효율적으로 처리하는 전용 엔진

NPU는 신경망 연산(특히 MAC: Multiply-Accumulate)을 빠르고 전력 효율적으로 처리하도록 설계됩니다. 스마트폰이나 노트북에서 배터리 부담 없이 AI 기능을 쓰게 만드는 주역이기도 합니다.

- 행렬 곱/합성곱/어텐션 등 반복 연산에 최적화

- 저전력·저지연 → 실시간 처리에 강함.

- 단, 범용성은 GPU보다 낮음(“정해진 일”을 잘함)

2-3. TPU: 데이터센터 규모 AI를 위한 “구글의 전용 ASIC”

TPU는 구글이 자체 워크로드를 위해 만든 Tensor 연산 특화 칩(ASIC)입니다. 대규모 학습/추론에서 효율과 스케일을 극대화하는 방향으로 설계되고, 주로 Google Cloud 환경에서 사용됩니다.

- 대규모 텐서 연산 최적화(대형 모델 학습/추론에 강함.)

- 데이터센터/클라우드 관점의 효율과 확장성에 초점

- 일반 소비자 접근성은 제한적(구글 생태계 중심)

III. 성능 & 전력 효율 비교

“어느 것이 더 빠른가?”는 어떤 작업(학습 vs 추론), 어떤 정밀도, 어떤 전력/열 제한에서 비교하느냐에 따라 달라집니다. 다만 경향성은 명확합니다.

| 항목 | NPU | GPU | TPU |

|---|---|---|---|

| 추론 속도 | 매우 우수(온디바이스 최적) | 우수 | 매우 우수(클라우드 최적) |

| 학습 성능 | 제한적(대개 비주력) | 최상급(표준) | 최상급(구글 워크로드) |

| 와트당 성능 | 최고 | 상대적으로 낮음 | 매우 높음 |

| 유연성 | 낮음(전용) | 매우 높음 | 낮음(전용) |

같은 “AI 작업”이라도, 배터리·발열·지연시간이 중요하면 NPU가, 모델을 학습시키거나 연구/실험이 많다면 GPU가, 초대형 클라우드 학습/추론을 구글 생태계에서 돌린다면 TPU가 유리해집니다.

IV. 실제 사용 예시

4-1. 스마트폰/AI PC: 온디바이스 AI의 시대

- 얼굴 인식, 사진/영상 AI 보정

- 음성 인식, 실시간 번역

- 로컬 LLM 실행(요약/검색/문서 보조 등)

추천: NPU

4-2. 연구·개발·스타트업: 반복 실험과 학습이 많은 환경

- 대규모 모델 학습(training)

- 파인튜닝, 실험 반복, 다양한 커스텀 연산

- 멀티태스크(시뮬레이션, 데이터 처리, 시각화 등)

추천: GPU

4-3. 클라우드 초대형 AI: 데이터센터 최적화

- 수백억~수천억 파라미터급 모델 학습

- 대규모 추론 서비스(저비용/고효율 목표)

추천: TPU(구글 클라우드 중심)

V. 왜 GPU가 아직 “AI의 주인공”인가?

NPU와 TPU가 강력해도 GPU가 계속 중심에 있는 가장 큰 이유는 범용성과 생태계입니다.

- 범용성: 학습과 추론을 모두 폭넓게 커버

- 개발 생태계: 프레임워크, 라이브러리, 최적화 툴이 풍부

- 모델 변화 대응력: 새로운 구조/연산이 나오면 GPU가 먼저 대응하기 쉬움

NPU는 “정해진 일을 가장 효율적으로 처리하는 전문 장비”, TPU는 “데이터센터 규모의 전용 공장 설비”, GPU는 “무엇이든 처리 가능한 강력한 범용 공장”에 가깝습니다.

VI. 상황별 선택 가이드

| 상황 | 최적 선택 | 이유 |

|---|---|---|

| 스마트폰/노트북에서 AI 기능(번역/보정/요약)을 배터리 효율 있게 | NPU | 저전력·저지연, 온디바이스 추론에 최적 |

| AI 모델 학습, 파인튜닝, 연구/실험이 많음 | GPU | 범용성 + 생태계 + 학습 성능 |

| 구글 클라우드에서 초대형 모델 학습/추론 | TPU | 대규모 텐서 연산 최적화, 데이터센터 효율 |

| 엣지/IoT/차량에서 실시간 AI 처리 | NPU | 전력·열 제약 환경에서 강점 |

| 빠른 프로토타이핑/다양한 워크로드 혼합 | GPU | 툴링과 호환성이 압도적 |

앞으로는 CPU + GPU + NPU가 한 기기 안에서 역할 분담하는 구조가 표준이 됩니다. 즉, “하나만 고르는” 것보다 “워크로드를 누구에게 맡길지”가 더 중요해집니다.

AI 가속기란 무엇인가? GPU, NPU, TPU 대세는?

AI 가속기는 인공지능 연산을 빠르게 처리하기 위한 특화된 하드웨어입니다. GPU, NPU, TPU 각각의 특징과 장단점을 비교하여 어떤 기술이 학습과 추론 환경에서 더 적합한지 분석하는 것의 다양한

www.msap.ai

VII. 한 줄 결론

GPU는 AI의 ‘범용 팔’, TPU는 ‘데이터센터의 전용 뇌’, NPU는 ‘기기 속 미니 뇌’입니다. 학습/연구가 중심이면 GPU(또는 구글 환경이면 TPU), 기기 내 실시간 AI와 전력 효율이 중요하면 NPU가 유리합니다.

'인공지능' 카테고리의 다른 글

| LLM 추론에서 NPU가 빨라지는 조건: 정밀도·양자화·메모리 대역폭 완전 정리 (0) | 2026.01.31 |

|---|---|

| LLM 비용 구조 완전 정리: Training 비용 vs Inference 비용 차이 (0) | 2026.01.31 |

| AI 학습(Training)과 추론(Inference) 완전 정리: 모델 개발 단계 vs 서비스 운영 단계 (0) | 2026.01.31 |

| AI 친화적인 프롬프트 작성 노하우: Role·Instruction·Goal·Context부터 고급 테크닉 7가지까지 (0) | 2026.01.31 |

| ChatGPT 5.2 출시: GPT 버저닝 업그레이드 역사와 개선 방향 총정리 (0) | 2026.01.22 |